テキストから音楽が作れる!Meta社の生成AI「MusicGen」の初心者向け使い方

プロンプト(テキスト)を入力しただけで、そのイメージに合わせた音楽を生成してくれるMeta社(旧Facebook社)の「MusicGen」の使い方を紹介します。

ChatGPTやBardとは異なり、MusicGenはWebサービスがありません。以下のGithub上に公開されているソースコードを利用する必要があります。

と書くと、難しそうだなと思う人も多いと思います。でも安心してください。簡単に実行できるように準備されています。必要なのは、クリック3回だけです。

事前準備

上記URLへアクセスして、ページ中段あたりまでスクロールすると、以下の画面のように「Colab」というセクションがあります。この中の緑で囲った部分をクリックしてください。

※今後場所が変わるかもしれません。「MusicGen_long_colab (max 60s melody 300s medium, small, large)」と記載されている行の「Open in Colab」ボタンを押してください。

すると、以下の画面が開きますので、再生ボタンのようなアイコンを押します。

ポップアップが表示されたら、「続行」を押してください。

数分経つと、以下の画面になります。「Running on public URL」の右に表示されているURLをクリックしてください。

※間違って、「Running on local URL」のほうをクリックしないように。

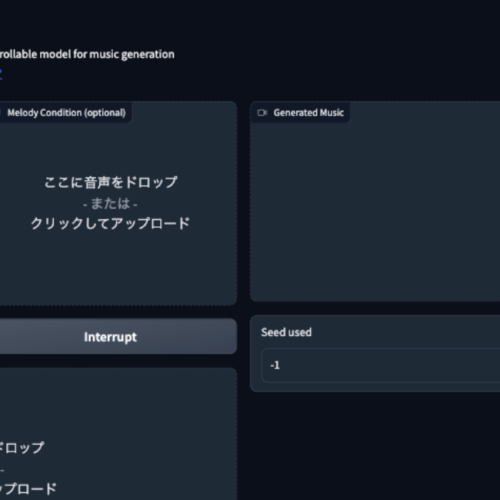

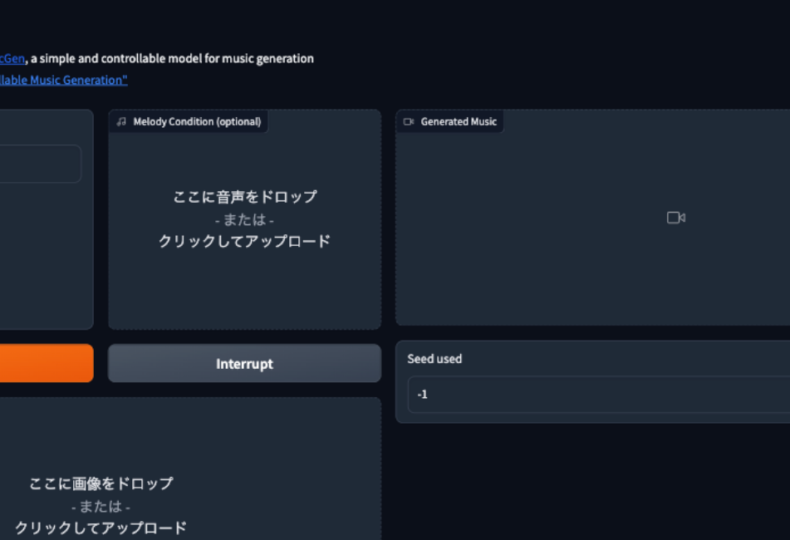

これで、以下のようなMusicGenのWebサイトが開きます。

なお、このURLは72時間しか使えないので、72時間経過したら再度「Open in Colab」ボタンを押すところから実行する必要があります。

MusicGenの基本的な使い方

使い方は簡単です。「Input Text」にプロンプト(テキスト)を入力して、「Generate」ボタンを押すだけです。2分ほどすると、10秒の音楽が出来上がります。

以下の例では、「A cheerful country song with acoustic guitars」と入力しています。

生成された音楽は、画面右側の波形の部分から再生やダウンロードができます。

10秒だと短い場合、画面中段の「Duration」で秒数を変更できますので、お好みの長さに設定してから、「Generate」ボタンを押してください。

その他、いくつかパラメーターがありますが、すべて紹介すると長くなるので触れません。ここまで紹介した内容だけで十分楽しめると思います。

MusicGenの学習データ

「MusicGen Model Card」に、以下の記載があります。

The model was trained on licensed data using the following sources: the Meta Music Initiative Sound Collection, Shutterstock music collection and the Pond5 music collection. See the paper for more details about the training set and corresponding preprocessing.

MusicGen Model Card

インターネット上の様々な音楽を学習データとして利用しているわけでなく、ちゃんと許可されたもののみ学習データに利用しているようですね。

最後までお読みいただきありがとうございました。